戒指现在开yun体育网,o1 等强推理模子的出现解释了 PRMs(过程级奖励模子)的有用性。

("幕后元勋" PRMs 崇敬评估推理过程中的每一步是否正确和有用,从而指点 LLMs 的学习标的。 )

但枢纽问题来了:咱们若何准确评估 PRMs 自身的性能?

手脚恢复,复旦大学、苏州大学,上海 AI Lab 等连结建议了 PRMBench,它包含 6,216 条全心假想的问题和 83,456 个身手级标签,用于评测模子细粒度的装假检测才气。

具体而言,现在主流的评估步伐通常侧重于最终成果的正确性,而忽略了对推理过程中良好入微的装假类型的识别。举例,一个推理身手可能存在冗余、部分正确、 致使统统装假等多种景象,简便的"正确 / 装假"标签难以捕捉其复杂性。

而 PRMBench 提供了一个更全面、更精细化的评估器具,不错更有用地识别 PRMs 的潜在谬误,促进关系算法的蜕变。

实验发现,现在 PRMs 在细粒度装假检测上仍有较大晋腾飞间。即使是线路最好的模子 Gemini-2-Thinking,其 PRMScore 也仅为 68.8,对付高于随即臆测的 50.0。

即使是挑升在身手级数据上老师过的 PRMs,其线路仍不如优秀的闭源通用模子,且多步推理才气挑升增强过的模子线路优于一般通用模子。

除此除外,推敲东说念主员还公布了一些其他发现和探讨。

PRMBench:一次针对 PRMs 的"全场所体检"

据先容,PRMBench 并非简便的"升级版"评估数据集,而是一套经过全心假想的"体检有规画",见识是全面考试 PRMs 在不同维度上的才气。

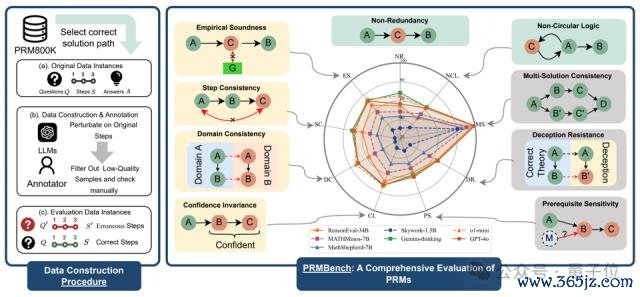

下图为 PRMBench 的主要结构,左侧部分展示了数据整理的过程,右侧部分展示了评估主题的示例以及测试模子的相对性能表。

其主要特质包括:

海量且精细的标注数据:包含 6,216 个全心假想的问题,并包含 83,456 个身手级别的标签,确保评估的深度和广度。

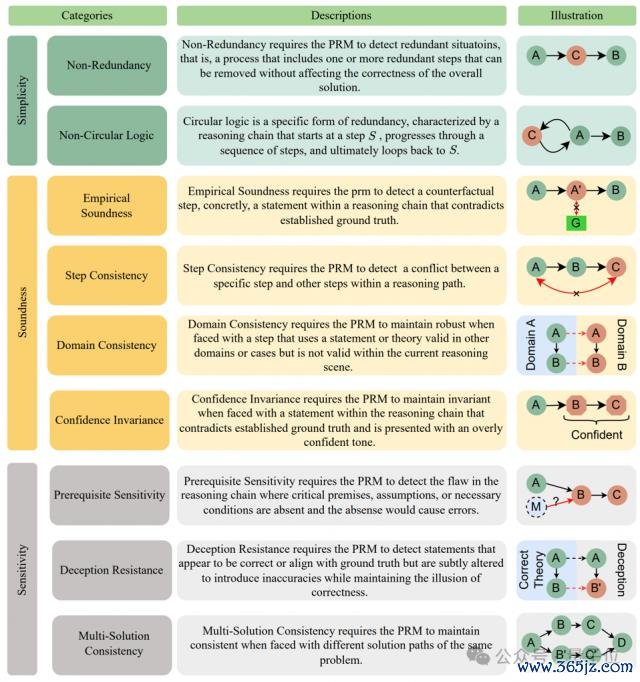

多维度、多眉目的评估体系:检朴洁性 ( Simplicity ) 、合感性 ( Soundness ) 和敏锐性 ( Sensitivity ) 三个主要维度开赴,进一步细分为九个子类别,举例非冗余性、非轮回逻辑、评价合感性、身手一致性、规模一致性、置信度不变性、前提条款敏锐性、 骗取违犯和一题多解一致性,奋力全面掩盖 PRMs 可能遭受的挑战。

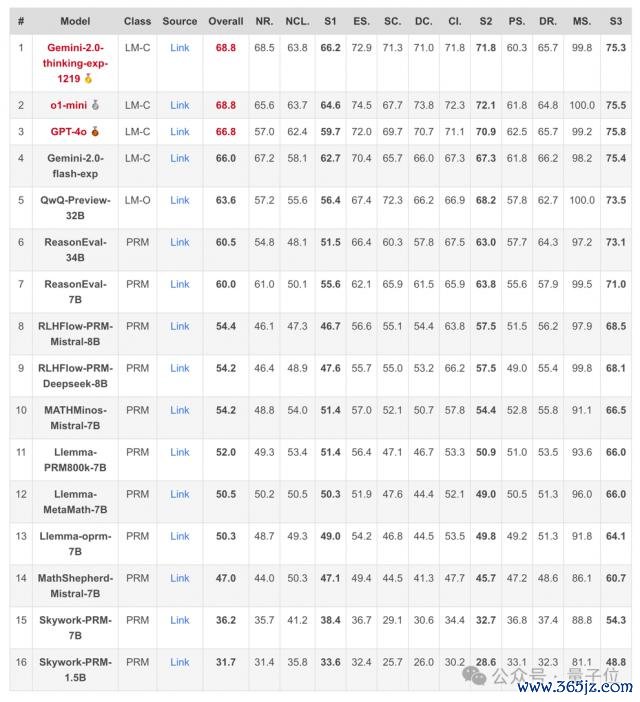

揭示现存 PRMs 的"盲区":推敲团队对 15 个代表性模子进行了平庸的实验,包括开源 PRMs 以及坚贞力通用说话模子教唆手脚 Critic Model 的模子。实验成果令东说念主讶异,也引东说念主深想。

具体来说,推敲的主要发现如下:

1、举座线路堪忧。即使是线路最好的模子 Gemini-2-Thinking,其 PRMScore 也仅为 68.8,对付高于随即臆测的 50.0。这标明,即使是早先进的 PRMs,在多步过程评估中仍然有弘远的晋腾飞间。

2、开源 PRMs 线路更弱。开源 PRMs 的平均 PRMScore 更低至 50.1,部分模子致使不如随即臆测,揭示了其可靠性和潜在老师偏差的问题。

3、"简陋性"成最大挑战。在 "简陋性" 维度上,即使是线路相对较好的 ReasonEval-34B,其 PRMScore 也骤降至 51.5,标明 PRMs 在识别推理过程中的冗余身手方面才气不及。

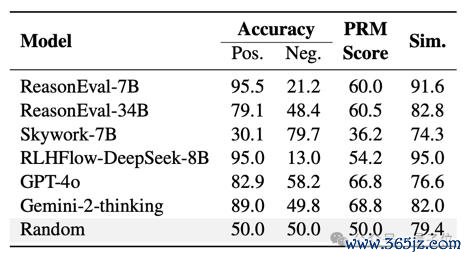

4、 "阳性偏好"时事显贵。部分模子,举例 ReasonEval-7B 和 RLHFlow-DeepSeek-8B,在评估中线路出显贵的"阳性偏好",难以分别正确和装假的身手。

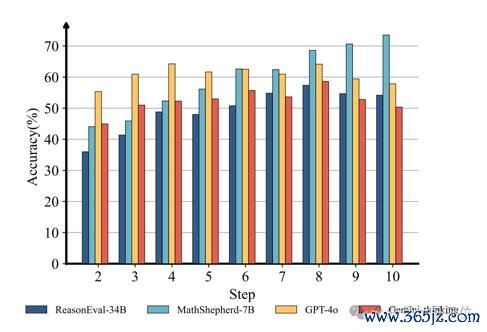

5、数据起首的洞悉。推敲发现,装假身手出现的位置也会影响 PRMs 的判断准确率。总的来说,跟着装假身手位置的后移,PRMs 的线路会渐渐晋升。

具体建议过程

底下先容一下具体推敲过程。

建议主要问题

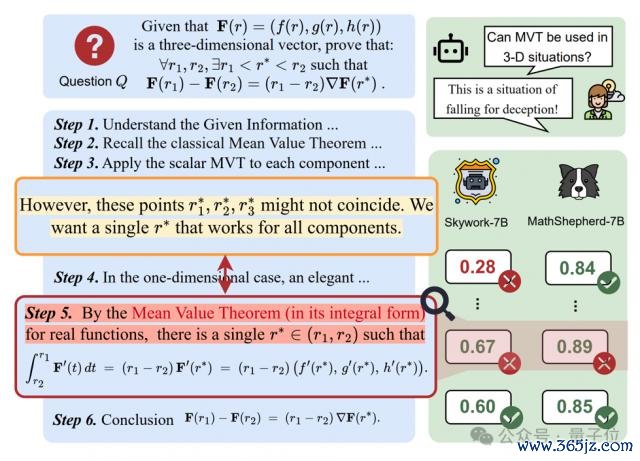

在一项需要举出反例的解释题施行中,推敲东说念主员不雅察到一个道理的时事:

即使大说话模子 ( o1 ) 自身相识到现时推理过程存在一些问题,仍然会产生装假的推理身手。

更令东说念主担忧的是, 当调用现存的 PRMs 去检测刚刚 o1 生成的推理过程时,成果却发现无数 PRMs 无法检测出这种细粒度的装假。

这一发现引出了一个枢纽问题:现时的 PRMs 是否具备检测推理过程中细粒度装假的才气?

下图为,当辩论模子所有拉格朗日中值定理关系问题时,o1 和 PRMs 可能会产生的装假。

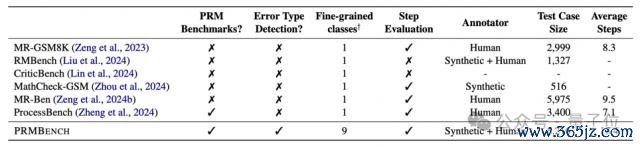

但是,现存针对 PRMs 评测而假想的 benchmark 大多只是抠门身手评判的对错,而冷落身手评判的装假类型, 贫瘠对装假类型的良好分类。

这也就意味着,现在穷乏这么好像评测 PRMs 在细粒度装假上线路的笼统 benchmark。

而这,恰是推敲东说念主员推出 PRMBench 这一精细化基准的压根原因。

他们但愿通过 PRMBench,冲破现存评估的局限,简直遴择出好像有用识别细粒度装假的"优秀" PRM。

下图为 PRMBench 与其他数据集对比。

PRMBench 构建

如下所示,PRMBench 包含三大评测主题:简陋性,合感性和敏锐性。

数据来源:基于 PRM800K 构建,最初筛选出其统统正确的问题、谜底以及解题身手手脚元数据。

装假引入:针对无数评测主题(前 8 个)使用 LLMs(非常是 GPT-4o)将多样细粒度的装假引入到统统正确的解题推理身手中。关于一题多解的情况,则使用多步推理增强过的说话模子为归并问题生成不同的正确解法非常推理身手。

东说念主工考证:严格的东说念主工审查,以确保引入装假的质地和关系性。

数据集统计:包含 6,216 个全心假想的问题,带有 83,456 个身手级别的标签。

评估对象:分为三个主要规模。简陋性评估冗余检测才气(非冗余性、非轮回逻辑);合感性评估 PRM 产生奖励的准确性和正确性(评价合感性、身手一致性、规模一致性、 置信度不变性);敏锐性评估对变化和误导性信息的鲁棒性(前提条款敏锐性、骗取违犯、多解一致性)。

实验与成果

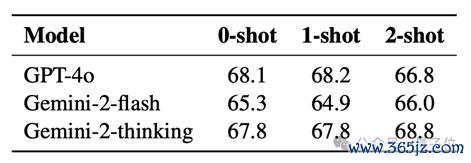

推敲东说念主员测试了 15 个模子,包括开源 PRMs ( Skywork-PRM, Llemma-PRM, MATHMinos-Mistral,MathShepherd-Mistral, RLHFlow-PRM ) 和教唆为 Critic Models 的优秀闭源说话模子 ( GPT-4o, o1-mini,Gemini-2 ) 。

评估谋略主要为:

负 F1 分数 ( Negative F1 Score ) :评估装假检测性能的主要谋略。

PRMScore:将 F1 和负 F1 相勾搭的结伴、程序化的分数,以反应举座才气。

不错看出,举座而言 PRMs 在多步过程评估中线路出有限的才气,其得分时常仅略高于随即臆测。

同期, 开源 PRMs 的线路时常不如坚贞力通用说话模子(如 o1, Gemini-thinking 等)教唆为 Critic Model 的线路更好。

并且相较于其他评测主题,检测冗余 ( 简陋性 ) 被解释对 PRMs 来说尤其困难。

另外,通过 PRMBench 下模子关于正确标签测试样例(阳性数据)和装假标签测试样例(阴性数据)的得分对等到一样度来看。

很多 PRMs 线路出对正确标签的偏好,难以正确识别装假标签测试样例(阴性数据)。

且从推理身手位于推理链中不同位置对模子 PRMScore 的影响来看,PRMs 的性能通常会跟着推理身手位于推理链中的位置渐渐靠后而提高。

终末从不同 Few shot 数量关于教唆为 Critic Model 的通用说话模子线路影响来看,少样本 ICL 的影响有限。

在 reward 过程中使用不同数量示例的 In-Context Learning 对闭源模子的性能影响不大。

小结一下,PRMBench 的发布,提醒咱们从头注目现存 PRMs 的才气范围。

按照推敲团队的说法,"咱们但愿 PRMBench 好像成为激动 PRM 评估和发展推敲的坚实基石"。

更多细节接待查阅原论文。

论文衔接:

https://arxiv.org/abs/2501.03124

款式主页:

https://prmbench.github.io/

Code:

https://github.com/ssmisya/PRMBench

Data:

https://huggingface.co/datasets/hitsmy/PRMBench_Preview

— 完 —

投稿请发邮件到:

ai@qbitai.com

标题注明【投稿】,告诉咱们:

你是谁,从哪来,投稿执行

附上论文 / 款式主页衔接,以及接洽姿首哦

咱们会(尽量)实时回复你

点这里� � 抠门我,牢记标星哦~

一键三连「共享」、「点赞」和「在看」

科技前沿进展日日相逢 ~

上一篇:开yun体育网因为生成视频速率太快-开云官网登录入口 开云app官网入口

下一篇:没有了